2010年08月24日

■ Macっ娘ならオートメータ君つかいたおすわよね

iPhoneといっしょにMacに乗り換える子が多いみたい。Mac買ったらまず開くのは「アプリケーション」フォルダなんだけど、左隅にいるちょっと気になるロボット君、「Automator」君っていうんだけど、知ってた?

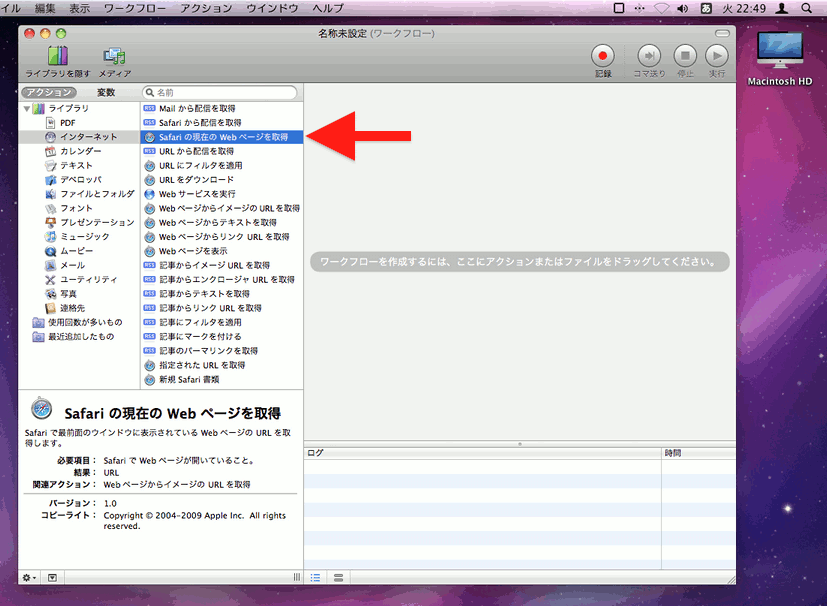

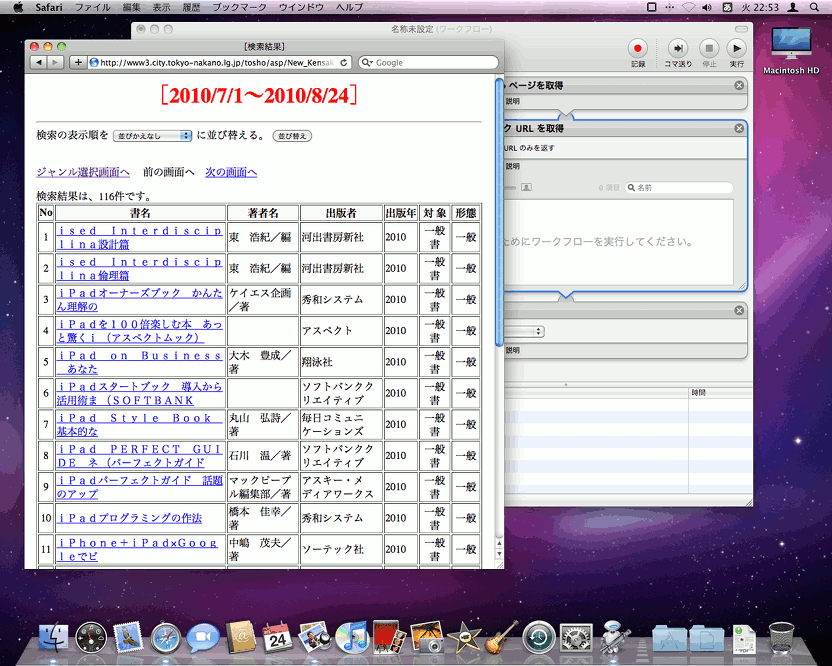

開くとこんな感じ。いろいろ並んでてよくわかんないけど、「インターネット」を選んで、「Safariの現在のWebページを取得」を選択。

これを右のところにドラッグして、追加。こんな感じ。

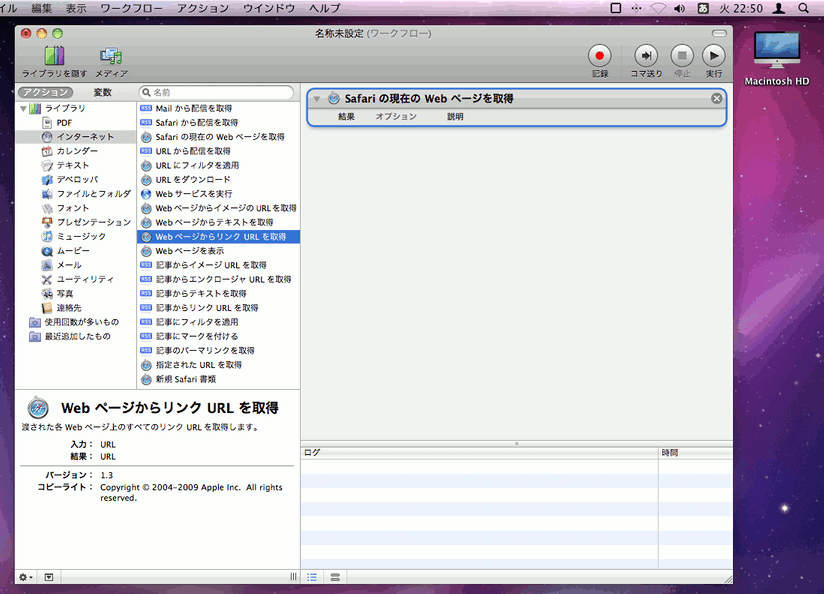

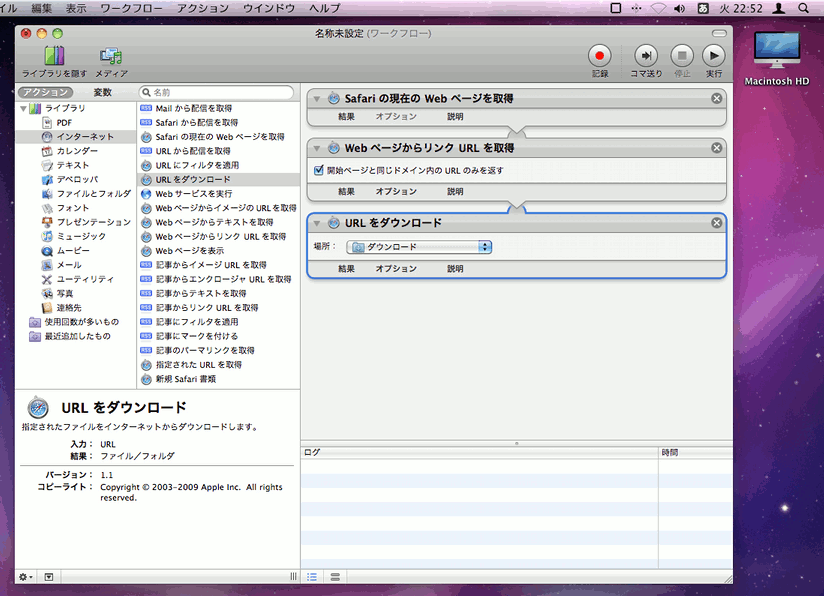

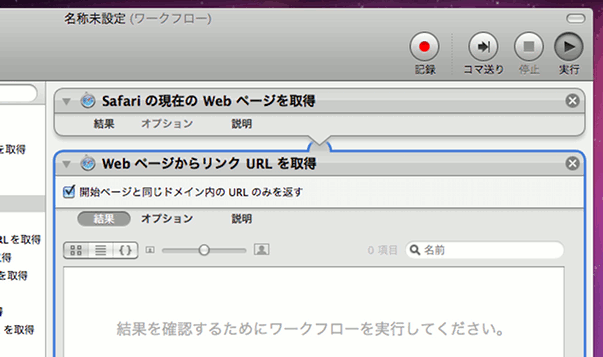

次は「WebページからリンクURLを取得」*1をドラッグして、その次に「URLをダウンロード」もドラッグね。

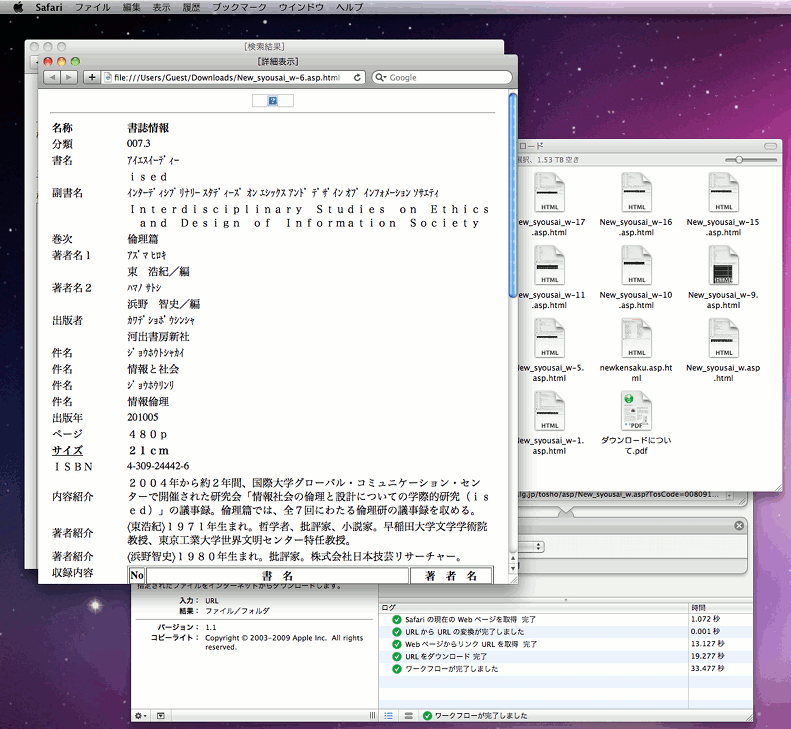

こんな感じになるんだけど、もう完成。あとは、Safariで図書館サイトに行って、新着図書のページへGo!

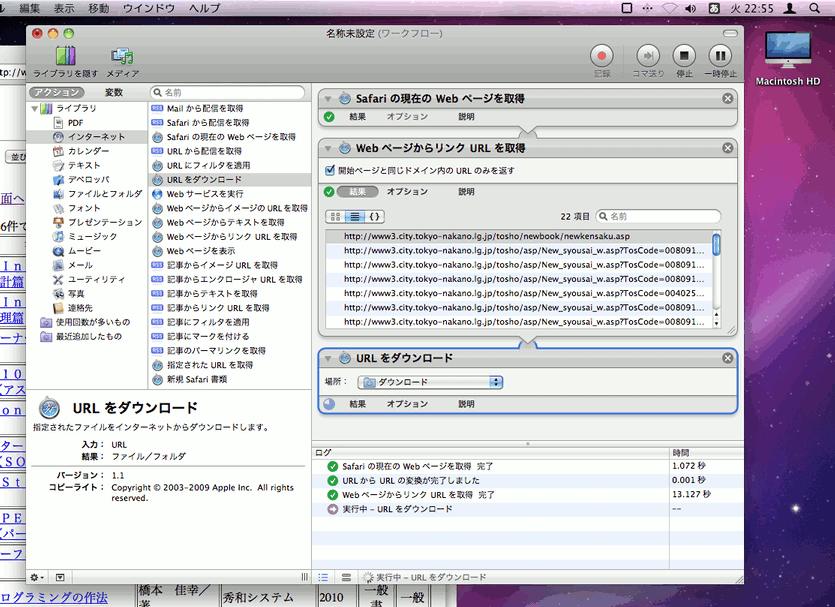

そしたら、Automator君の「実行」ボタンを押すだけ!

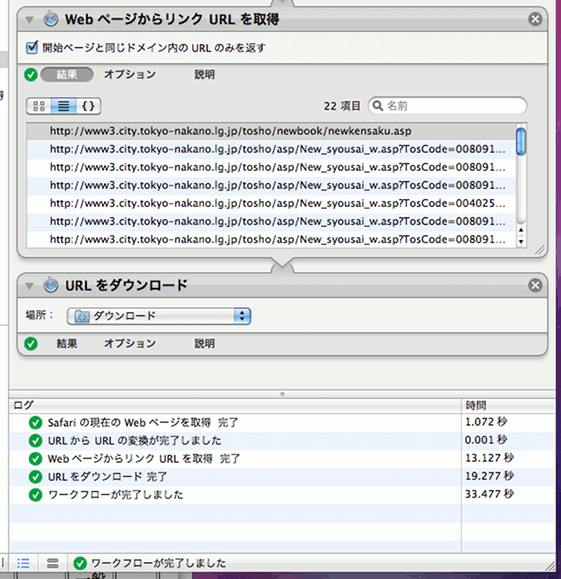

リンク先のアドレスが抽出されて、

もりもり取りにいって、はい終了。

22ページ取りにいって19.277秒。けっこうアグレッシブ。ウェイトは1秒より短いみたい。

ばっちり取れてる。

これが世界標準のMacの機能。5年前からあったみたい。クローラーキモいなんて言ってるコーダー女子もいるみたいだけど、パソコンくんばっか相手にしてると時代に取り残されちゃう。

- 岡崎市立中央図書館事件に対するカーリルの見解, カーリルのブログ「カリブロ」, 2010年8月21日

既にプログラミングという技術は決して特別なものではなく、誰でも開発に参加できる時代です。

至言だわ。

ちなみに、Automator君は /robots.txt は見ないみたい。見た目はロボットだけど。

*1 2006年の「Mac OS X 10.4.7 Update (delta) について」によると「Automator の「Web ページからイメージの URL を取得」アクションや「Web ページからリンク URL を取得」アクションで、Cookie やセッションを要求する Web サイト(特に、URL と共に認証情報が渡される場合)に対するサポートが、今まで以上に充実しました。」とのこと。